El crawl budget o presupuesto de rastreo es uno de esos conceptos técnicos del SEO que muchos propietarios de sitios web pasan por alto, pero que puede marcar una diferencia abismal en el rendimiento orgánico. Desde nuestra experiencia, hemos visto cómo sitios con contenido excelente y una arquitectura bien pensada fracasan simplemente porque Google no rastrea sus páginas más importantes.

Vamos a desglosar todo lo que necesitas saber sobre el presupuesto de rastreo, por qué es crucial para tu estrategia de posicionamiento web y, lo más importante, cómo optimizarlo para que los motores de búsqueda prioricen tu contenido más valioso.

Acceso rápido

- 1 ¿Qué es el crawl budget exactamente?

- 2 Los dos pilares fundamentales del crawl budget

- 3 ¿Por qué es importante el crawl budget para tu estrategia SEO?

- 4 Cómo monitorizar tu crawl budget en Google Search Console

- 5 Estrategias avanzadas para optimizar tu crawl budget en 2025

- 5.1 1. Mejora drásticamente la velocidad de tu sitio

- 5.2 2. Construye una arquitectura de enlaces internos estratégica

- 5.3 3. Mantén actualizado y limpio tu sitemap XML

- 5.4 4. Bloquea URLs de bajo valor con robots.txt

- 5.5 5. Elimina redirecciones innecesarias y cadenas

- 5.6 6. Identifica y corrige enlaces rotos

- 5.7 7. Gestiona el contenido duplicado con canonicals

- 5.8 8. Actualiza y añade contenido de forma regular

- 6 Crawl budget y buscadores de inteligencia artificial

- 7 Preguntas frecuentes sobre crawl budget

- 7.1 ¿Cuánto crawl budget tiene mi sitio?

- 7.2 ¿Mi sitio pequeño necesita preocuparse por el crawl budget?

- 7.3 ¿Bloquear recursos CSS/JS en robots.txt ahorra crawl budget?

- 7.4 ¿Las páginas bloqueadas con noindex consumen crawl budget?

- 7.5 ¿Con qué frecuencia debo revisar mi crawl budget?

- 7.6 ¿Cómo sé si tengo problemas de crawl budget?

- 7.7 ¿El crawl budget afecta el posicionamiento en buscadores de IA como ChatGPT?

- 7.8 Desde nuestra experiencia….

¿Qué es el crawl budget exactamente?

El presupuesto de rastreo es el número de páginas que Googlebot (el robot de Google) está dispuesto y es capaz de rastrear en tu sitio web durante un período de tiempo determinado, típicamente 24 horas.

Imaginemos que Googlebot es un visitante que pasa por tu web regularmente para ver qué hay de nuevo y decidir qué vale la pena mostrar en los resultados de búsqueda. Sin embargo, este visitante no tiene tiempo ilimitado; cada sitio recibe una «asignación» específica de tiempo y recursos de rastreo.

Si tienes 10.000 URLs en tu sitio pero Googlebot solo tiene capacidad para rastrear 2.000 en un día, tendrá que priorizar. Y aquí radica el problema: sin las señales correctas, el bot podría desperdiciar ese valioso tiempo en páginas de bajo valor mientras ignora tus mejores contenidos.

Los dos pilares fundamentales del crawl budget

Según la documentación oficial de Google y las declaraciones de Gary Illyes (analista de búsqueda de Google), el crawl budget se determina por dos factores principales:

Demanda de rastreo (crawl demand)

La demanda de rastreo refleja con qué frecuencia Google quiere rastrear tu sitio basándose en su importancia percibida. Dentro de este concepto encontramos tres elementos clave:

- Popularidad de las páginas: Google prioriza páginas que tienen más backlinks de calidad y atraen mayor tráfico. Estas señales indican al algoritmo que tu contenido es importante y merece ser rastreado con mayor frecuencia.

- Frescura del contenido: Los sitios que publican y actualizan contenido regularmente reciben mayor atención del rastreador. Por ejemplo, los portales de noticias que publican múltiples veces al día disfrutan de una demanda de rastreo muy alta.

- Inventario percibido: Google intentará rastrear todas las páginas que conoce de tu sitio, a menos que le indiques específicamente que no lo haga mediante robots.txt o códigos de estado HTTP específicos.

Límite de capacidad de rastreo (crawl capacity limit)

El límite de capacidad es el máximo número de solicitudes que Googlebot puede hacer a tu sitio sin afectar negativamente su rendimiento ni sobrecargar tu servidor.

Este límite se ve influenciado principalmente por:

- Salud de tu servidor: Si tu sitio responde rápidamente a las solicitudes de Google, tu capacidad de rastreo puede aumentar. Por el contrario, si presenta lentitud o errores del servidor, el límite disminuye.

- Límites de recursos de Google: Aunque Google tiene una infraestructura masiva, sus recursos no son infinitos. El buscador debe priorizar qué sitios rastrear con mayor intensidad.

¿Por qué es importante el crawl budget para tu estrategia SEO?

A lo largo de nuestros años ofreciendo servicios de SEO técnico, nos hemos encontrado con situaciones donde webs perfectamente optimizadas no posicionaban simplemente porque sus páginas no estaban siendo rastreadas o indexadas.

Consecuencias de un crawl budget mal gestionado

- Páginas importantes sin indexar: Si Google gasta su presupuesto en páginas de bajo valor, tus mejores contenidos pueden quedarse sin rastrear y, por tanto, sin posibilidad de posicionar.

- Demoras en la indexación: Cuando lanzas productos nuevos o publicas contenido relevante, quieres que aparezca en los resultados lo antes posible. Un crawl budget optimizado acelera este proceso.

- Información desactualizada en las SERPs: Si Google no vuelve a rastrear tus páginas con frecuencia, los usuarios podrían ver información obsoleta en los resultados de búsqueda.

- Desperdicio de recursos: Cada segundo que Googlebot pasa en páginas irrelevantes es tiempo que no dedica a descubrir y valorar tu contenido estratégico.

¿A quién afecta más el crawl budget?

Seamos honestos: no todos los sitios web necesitan obsesionarse con la optimización del presupuesto de rastreo. Para la mayoría de sitios pequeños y medianos, Google es suficientemente eficiente en su rastreo.

Sin embargo, debes prestar atención especial al crawl budget si tu sitio:

- Tiene más de 10.000 páginas (especialmente tiendas online grandes)

- Publica contenido nuevo constantemente (portales de noticias, foros, blogs muy activos)

- Añade frecuentemente grandes volúmenes de páginas nuevas

- Presenta muchas redirecciones 301 o cadenas de redirecciones

- Muestra en Search Console un alto número de URLs con estado «Descubierto – actualmente no indexado»

Cómo monitorizar tu crawl budget en Google Search Console

Antes de optimizar, necesitas comprender el estado actual de tu presupuesto de rastreo. Google Search Console es la herramienta fundamental para esta tarea.

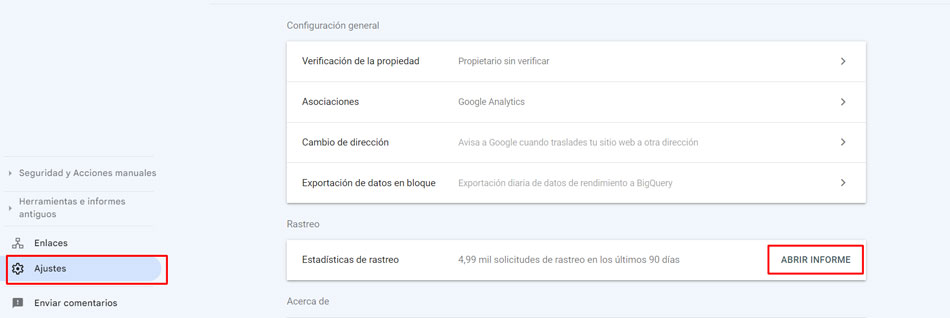

Accediendo a las estadísticas de rastreo

- Accede a tu propiedad de Search Console

- Navega a Configuración en el menú lateral

- En la sección «Rastreo», verás el número de solicitudes de rastreo de los últimos 90 días

- Haz clic en «Abrir informe» para obtener información detallada

Interpretando los datos clave

- Solicitudes de rastreo totales: Número total de veces que Googlebot ha solicitado páginas de tu sitio en los últimos 90 días.

- Tamaño total de descarga: La cantidad de datos que los rastreadores de Google han descargado al acceder a tu web.

- Tiempo promedio de respuesta: Cuánto tarda tu servidor en responder a una solicitud del rastreador (medido en milisegundos). Un valor alto indica problemas de rendimiento.

- Estado del host: Indica si tu sitio ha tenido problemas para cumplir con las demandas de rastreo de Google.

- Desglose de solicitudes: Información agrupada por tipo de respuesta (200, 404, etc.), tipo de archivo, propósito (descubrimiento vs actualización) y tipo de bot.

Estrategias avanzadas para optimizar tu crawl budget en 2025

Basándonos en casos reales que hemos gestionado y en las tendencias más recientes del SEO técnico, estas son las estrategias más efectivas:

1. Mejora drásticamente la velocidad de tu sitio

La velocidad de carga no solo es un factor de ranking y experiencia de usuario; también impacta directamente en tu crawl budget. Si tus páginas cargan rápidamente, Googlebot puede rastrear más URLs en menos tiempo.

Acciones concretas:

- Optimiza y comprime todas las imágenes (formatos modernos como WebP)

- Minimiza CSS, JavaScript y HTML

- Implementa un CDN (Content Delivery Network) para servir contenido desde servidores geográficamente cercanos al usuario

- Habilita la compresión gzip o brotli

- Reduce las solicitudes HTTP mediante la combinación de archivos cuando sea posible

- Implementa lazy loading para imágenes y videos

2. Construye una arquitectura de enlaces internos estratégica

El enlazado interno no solo ayuda a los usuarios a navegar; es fundamental para guiar a Googlebot hacia tus páginas más importantes.

Principios fundamentales:

- Crea una estructura jerárquica clara donde la homepage esté en la cima y las páginas se ramifiquen en categorías y subcategorías lógicas.

- Asegúrate de que todas las páginas importantes estén a máximo 3 clics de la homepage.

- Evita las páginas huérfanas (páginas sin ningún enlace interno apuntando hacia ellas). Google puede encontrarlas, pero es mucho más difícil.

- Utiliza anchor text descriptivo que indique claramente el contenido de la página destino.

- Enlaza desde páginas de alta autoridad hacia contenidos nuevos o menos populares para distribuir el «link juice».

3. Mantén actualizado y limpio tu sitemap XML

Tu sitemap XML funciona como un mapa que le entregas a Googlebot indicándole dónde están tus páginas más importantes.

Mejores prácticas:

- Incluye ÚNICAMENTE páginas que quieres que aparezcan en resultados de búsqueda

- Mantén el sitemap actualizado automáticamente cuando añadas o elimines páginas

- Utiliza la etiqueta

<lastmod>para indicar cuándo se actualizó cada URL por última vez - Si tu sitio es muy grande, divide el sitemap en varios archivos y utiliza un sitemap índice

- Envía el sitemap a Google Search Console y monitoriza su estado regularmente

4. Bloquea URLs de bajo valor con robots.txt

El archivo robots.txt te permite indicar explícitamente a Googlebot qué páginas NO debe rastrear, liberando presupuesto para contenido más valioso.

Páginas típicas que deberías bloquear:

- Páginas de agradecimiento tras formularios

- URLs de búsqueda interna con parámetros

- Áreas de administración o login

- Páginas duplicadas generadas por filtros o variaciones

- Archivos privados o recursos que no aportan valor SEO

- Páginas de carrito de compra o checkout en ecommerce

Importante: Bloquear una página en robots.txt impide su rastreo pero NO garantiza que no se indexe si hay enlaces apuntando hacia ella. Para evitar la indexación, usa la meta etiqueta noindex.

5. Elimina redirecciones innecesarias y cadenas

Las redirecciones consumen tiempo de rastreo. Cada vez que Googlebot encuentra una redirección, debe seguirla hasta llegar a la URL final.

Problemas comunes:

- Cadenas de redirecciones: Ocurren cuando hay múltiples saltos (URL A → URL B → URL C → URL D). Google recomienda redireccionar siempre directamente a la URL final.

- Redirecciones temporales (302): Cuando deberían ser permanentes (301). Esto confunde al rastreador sobre cuál es la versión definitiva.

- Redirecciones innecesarias en enlaces internos: Si sabes que una página redirige, actualiza tus enlaces internos para que apunten directamente a la URL final.

6. Identifica y corrige enlaces rotos

Los enlaces rotos (404) desperdician crawl budget porque el bot intenta acceder a páginas que ya no existen.

Aunque tener algunos 404 es normal y aceptable (las páginas eliminadas deberían devolver este código), un volumen excesivo indica problemas de mantenimiento.

Soluciones:

- Audita regularmente tu sitio con herramientas como Screaming Frog o Sitebulb

- Revisa el informe de cobertura en Search Console

- Decide para cada 404 si debes crear una redirección 301 hacia contenido relevante o simplemente dejar el error (si la página no tiene valor)

- Actualiza o elimina los enlaces internos que apuntan a páginas 404

7. Gestiona el contenido duplicado con canonicals

El contenido duplicado es uno de los mayores desperdicios de crawl budget. Si Google rastrea múltiples versiones del mismo contenido, está malgastando recursos.

Estrategias efectivas:

- Implementa correctamente las etiquetas canonical para indicar la versión principal de páginas similares.

- Usa redirecciones 301 cuando una de las versiones duplicadas no necesita ser accesible.

- Evita la creación de infinitas variaciones de URL mediante parámetros (común en filtros de ecommerce).

- Configura adecuadamente tus categorías, etiquetas y taxonomías en CMS como WordPress para evitar duplicación.

8. Actualiza y añade contenido de forma regular

Google prioriza sitios que muestran señales de actividad y actualización constante. Un sitio estático recibe menos atención del crawler.

Acciones recomendadas:

- Publica contenido nuevo con regularidad (aunque sea semanal o quincenal)

- Actualiza artículos antiguos con información fresca y relevante

- Añade fechas de última actualización visibles en tus contenidos

- Mantén un calendario editorial consistente

Crawl budget y buscadores de inteligencia artificial

Con el auge de ChatGPT, Perplexity,Copilot, Claude y otros sistemas de IA que rastrean y citan contenido web, el concepto de «presupuesto de rastreo» se expande más allá de Google.

Estos sistemas también tienen limitaciones en cuánto pueden rastrear de cada sitio. Optimizar tu crawl budget tradicional te beneficia indirectamente con estos nuevos rastreadores, ya que:

- Sitios rápidos y bien estructurados son más fáciles de procesar para cualquier bot

- Contenido claramente jerarquizado y bien canonizado ayuda a la IA a identificar tus mejores recursos

- Reducir páginas de bajo valor aumenta la densidad de contenido valioso que la IA puede descubrir

Además, muchos de estos sistemas respetan las directrices de robots.txt, permitiéndote controlar su acceso si lo deseas.

Preguntas frecuentes sobre crawl budget

¿Cuánto crawl budget tiene mi sitio?

No existe una cifra fija. El crawl budget varía según el tamaño, autoridad, velocidad y frescura de tu sitio. Puedes ver las solicitudes de rastreo históricas en Google Search Console, pero Google no publica números exactos de «presupuesto asignado».

¿Mi sitio pequeño necesita preocuparse por el crawl budget?

Probablemente no. Si tienes menos de 5.000-10.000 páginas y Google indexa tu contenido nuevo el mismo día que lo publicas, tu crawl budget es suficiente. Enfócate primero en otros aspectos del SEO.

¿Bloquear recursos CSS/JS en robots.txt ahorra crawl budget?

No es recomendable. Aunque técnicamente ahorra algunos rastreos, impide que Google renderice correctamente tus páginas, lo cual puede perjudicar significativamente tu SEO. Google recomienda permitir el rastreo de todos los recursos necesarios para el renderizado.

¿Las páginas bloqueadas con noindex consumen crawl budget?

Sí, todavía se rastran (para ver la etiqueta noindex), pero no se indexan. Si quieres evitar completamente el rastreo, usa robots.txt. Sin embargo, combinar ambos puede enviar señales contradictorias.

¿Con qué frecuencia debo revisar mi crawl budget?

Para sitios medianos o grandes, revisa las estadísticas de rastreo en Search Console al menos mensualmente. Tras cambios importantes en tu sitio (migraciones, grandes actualizaciones, rediseños), monitoriza semanalmente durante el primer mes.

¿Cómo sé si tengo problemas de crawl budget?

Las señales principales incluyen: un alto número de páginas con estado «Descubierto – actualmente no indexado» en Search Console, demoras significativas en la indexación de contenido nuevo, y descenso en las solicitudes de rastreo sin motivo aparente. Analiza tus estadísticas de rastreo regularmente para detectar estos problemas.

¿El crawl budget afecta el posicionamiento en buscadores de IA como ChatGPT?

Indirectamente sí. Los rastreadores de IA como GPTBot también tienen límites de rastreo. Optimizar tu sitio para que sea rápido, esté bien estructurado y libre de contenido duplicado facilita que cualquier bot (incluidos los de IA) procese eficientemente tu contenido y te cite en sus respuestas.

Desde nuestra experiencia….

El presupuesto de rastreo puede parecer un concepto técnico y abstracto, pero su impacto en el rendimiento SEO es completamente tangible. Hemos visto sitios aumentar su indexación en un 40-60% simplemente optimizando cómo Googlebot gasta su tiempo en sus páginas.

Sabemos que dominar estos aspectos fundamentales es lo que separa estrategias mediocres de estrategias ganadoras. No se trata solo de producir buen contenido, sino de asegurarte de que los motores de búsqueda puedan encontrarlo, rastrearlo e indexarlo eficientemente.

Si gestionas un sitio grande, publicas contenido frecuentemente o has notado problemas de indexación, invertir tiempo en optimizar tu crawl budget puede ser el cambio que desbloquee tu verdadero potencial orgánico.